Dans l'épisode d'aujourd'hui, nous nous appuyons sur les conclusions des parties précédentes, dans lesquelles nous avons tenté d'identifier et de mesurer les facteurs susceptibles d'affecter la véritable performance hors échantillon des stratégies. ( WFOS )

Cette série complète est le résultat d'une recherche menée en 2019/2020 qui s'est concentrée thématiquement sur la méthodologie utilisée pour évaluer et sélectionner les stratégies générées dans StrategyQuant.

Les première partie a été consacré à l'impact de la complexité de la stratégie et du nombre de transactions sur la performance potentielle dans la fourchette de l'échantillon réel, et le deuxième partie à la sensibilité de la stratégie à des écarts plus élevés.

Les troisième partie a traité de l'influence des indicateurs de classement traditionnels sur les performances des stratégies dans l'échantillon réel ( WFOS ).

Dans la partie d'aujourd'hui, nous allons appliquer des techniques simples de sélection de caractéristiques et essayer d'évaluer les facteurs qui influencent la performance dans la période True out of sample (WFOS). Les méthodes utilisées pour cette analyse peuvent être consultées à l'adresse https://machinelearningmastery.com/ ou dans l'excellent livre Data Preparation for Machine Learning.

Qu'est-ce que j'entends par "caractéristiques" ? Imaginons que nous générions des stratégies. Définissons la période de données en échantillon et la période de données hors échantillon. La période hors échantillon est celle que nous n'utilisons pas pour le classement ou la sélection de stratégies lors de la génération de stratégies.

Par caractéristiques, nous entendons les mesures qualitatives des stratégies dans leur période hors échantillon. La sélection de stratégies à partir de données d'échantillon n'est pas très utile lorsqu'elle est utilisée génétiquement en raison du surajustement. De plus, leurs effets sont étudiés sur un échantillon de données que nous n'avons pas du tout utilisé pour leur développement.

L'objectif est d'identifier ces facteurs dans une période hors échantillon qui pourraient avoir une valeur prédictive hypothétique pour la stratégie de facteur de profit dans la période hors échantillon réelle. (WFOS )

En utilisant la méthode simple, nous mesurerons la corrélation entre les indicateurs dans la période hors échantillon et le facteur de profit dans la véritable période hors échantillon. (WFOS )

Il existe plusieurs options pour choisir un coefficient de corrélation. Chacune a ses avantages et ses inconvénients. Dans notre cas, le facteur décisif sera la résistance aux valeurs aberrantes. Vous pouvez trouver de nombreuses sources et opinions sur l'internet, notre choix se porte sur le coefficient de corrélation de Spearman. Vous trouverez plus d'informations sur ce sujet sur Stackexchange dans cette page. forum

Dans l'analyse suivante, nous analyserons la stratégie en fonction de la sélection et des conclusions que nous avons faites dans les parties précédentes.

Nous simulerons 4 scénarios :

- Ensemble de données sans sélection (toutes les stratégies)

- Ensemble de données avec des stratégies de complexité 4 à 6

- Ensemble de données avec des stratégies de complexité 4 à 6 et avec un nombre moyen de transactions par an dans l'intervalle 30 à 80

- Ensemble de données avec des stratégies de complexité 4-6 et avec un nombre moyen de transactions par an dans l'intervalle 30 à 80 et un ratio d'écart supérieur à 0,8.

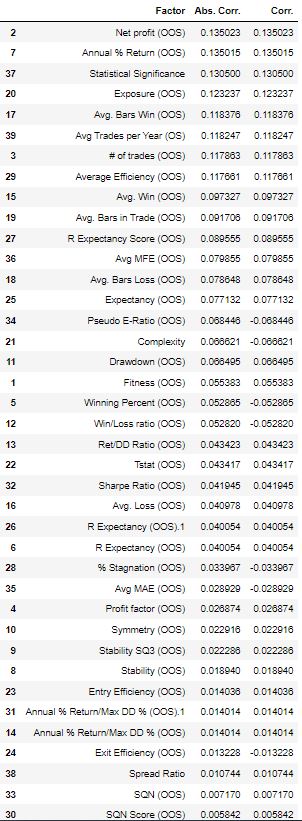

1. Scénario - Ensemble de données sans aucune sélection (toutes les stratégies)

Dans cet exemple, nous n'utilisons pas de sélection. En d'autres termes, nous prenons l'ensemble des données brutes et analysons la corrélation entre les paramètres de la stratégie hors échantillon et le facteur de profit dans la véritable période hors échantillon ( WFOS ).

Dans les colonnes ci-dessus, nous avons dressé la liste :

- Facteur est le nom de la métrique de la stratégie dans la période hors échantillon.

- Coefficient de corrélation absolu

- Coefficient de corrélation

Plus le coefficient de corrélation de Spearman absolu est élevé, plus la relation entre le facteur et le facteur de profit est forte dans la période True out of sample.

En d'autres termes, plus les stratégies sont présentes depuis longtemps sur le marché, plus le facteur de profit est susceptible d'être élevé.

Un autre facteur qui mérite l'attention et qui vient en premier est la signification statistique, qui est la relation entre le nombre de transactions dans une stratégie et sa complexité. En d'autres termes, plus une stratégie effectue de transactions et moins elle est complète, plus sa signification statistique est élevée.

2. Scénario - Stratégies d'une complexité de 4 à 6

Dans cet ensemble de données, je ne prendrai en considération que les stratégies d'une complexité de 3 à 6. Je considère la complexité comme un facteur clé. Une bonne citation qui capture l'essence de cette idée est la suivante

"Si l'algorithme est trop complexe ou trop souple (par exemple, s'il a trop de caractéristiques d'entrée ou s'il n'est pas correctement régularisé), il peut finir par "mémoriser le bruit" au lieu de trouver le signal.

3. Scénario - Ensemble de stratégies d'une complexité de 4 à 6 a avec une moyenne de transactions par an de 30 à 80

Nous travaillons dans des conditions de surajustement possible. L'une des approches de base pour contrer ce problème consiste à augmenter le nombre d'observations, c'est-à-dire le nombre de transactions, en plus d'une complexité moindre. Une fois encore, le raisonnement sur le nombre de transactions est basé sur la littérature sur l'apprentissage automatique mais aussi sur l'excellente série de Martin Tinsley que l'on peut trouver sur youtube sous le titre Backtesting et optimisation algorithmique pour les alphas.

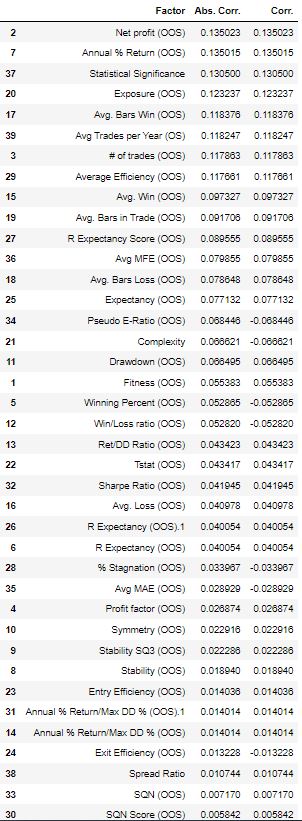

4. Scénario - Ensemble de stratégies d'une complexité de 4 à 6 a avec une moyenne de transactions par an de 30 à 80 et un ratio d'écart > 0,8

Dans le tableau ci-dessus, nous voyons % Annual Return, Exposure, et Avg.Win dans les premières places.

En d'autres termes : Si je devais sélectionner des stratégies pour la période 1986-2022 et utiliser l'échantillon 2006-2022, je commencerais par des stratégies basées sur ces mesures.

Résumé

Si nous examinons attentivement les différents scénarios, nous constatons que certains facteurs se répètent.

En d'autres termes, filtrer les stratégies en fonction de leur exposition, de la moyenne des gains et du bénéfice net annuel peut être un bon point de départ pour choisir une stratégie et l'évaluer. Win, et le bénéfice net annuel peut être un bon point de départ pour choisir une stratégie d'évaluation.

Notons également que certains facteurs traditionnels tels que le ratio de Sharpe et le ratio RetDD sont constamment moins bien classés dans notre analyse. Cette analyse peut être réalisée pour n'importe quel marché et n'importe quel horizon temporel.

En utilisant StrategyQuantX, il est possible de collecter des données et de les évaluer dans un environnement externe. J'ai utilisé python mais vous pouvez utiliser excel ou n'importe quoi d'autre.

Il s'agit d'une version très simplifiée de ce que j'utilise réellement, mais c'est un bon point de départ pour vos propres recherches. Avec StrategyQuantX, il est possible de collecter une grande quantité de données en utilisant des projets personnalisés exportant des données d'une base de données et c'est à vous de décider comment utiliser cet outil.

Merci pour cet article

Oui, merci beaucoup pour cet article ! !!!